Искусственный интеллект

Самокритика машин: как нейросети улучшают анализ текста

Автор: Денис Аветисян

Новый подход к автоматическому анализу качественных данных использует «второй взгляд» нейросети для выявления и исправления ошибок в первоначальной разметке.

Исследование демонстрирует, что двухэтапный процесс, включающий первичную кодировку текста большой языковой моделью и последующую критическую оценку второй моделью, значительно повышает надежность качественного анализа за счет снижения количества ложных срабатываний.

Несмотря на впечатляющие возможности больших языковых моделей (LLM) в автоматизированном качественном анализе, их применение часто сопряжено с высокой вероятностью ошибок. В статье «Self-reflection in Automated Qualitative Coding: Improving Text Annotation through Secondary LLM Critique» представлен двухэтапный подход, использующий LLM для первичной кодировки текста и последующего анализа «критика» — второго LLM, корректирующего неточности. Показано, что такая «саморефлексия» значительно снижает количество ложных срабатываний и повышает надежность результатов качественного анализа. Возможно ли дальнейшее совершенствование подобных систем, приближающее их к уровню экспертной оценки и позволяющее эффективно работать с большими объемами текстовых данных?

Иллюзии и Опасности Автоматизированного Кодирования

Анализ качественных данных играет фундаментальную роль в широком спектре исследований, от социологии до психологии и антропологии, однако этот процесс традиционно требует значительных временных затрат. Тщательное кодирование, категоризация и интерпретация данных, полученных из интервью, фокус-групп или открытых вопросов, часто становятся узким местом, замедляющим прогресс исследований. Исследователи сталкиваются с необходимостью ручного изучения больших объемов текстовой информации, что требует высокой концентрации внимания и подвержено человеческим ошибкам. В результате, получение надежных и валидных выводов может затянуться на месяцы или даже годы, ограничивая возможности для своевременного получения результатов и принятия обоснованных решений.

Непосредственное применение больших языковых моделей к сложным задачам кодирования качественных данных сопряжено с рядом трудностей. Хотя потенциал автоматизации анализа текстов очевиден, модели часто демонстрируют склонность к поверхностным интерпретациям, упуская важные нюансы и контекст. Ошибки в кодировке, возникающие из-за неточного понимания смысла, могут привести к искажению результатов исследования и неверным выводам. Кроме того, языковые модели могут быть предвзяты, отражая стереотипы, присутствующие в данных, на которых они обучались, что требует тщательного контроля и коррекции. Таким образом, для успешного использования LLM в кодировании необходима не просто автоматизация, но и разработка методов, обеспечивающих точность, надежность и отсутствие систематических ошибок.

Для эффективного использования больших языковых моделей (LLM) в кодировании качественных данных требуется не просто их применение, но и тщательная адаптация существующих методологических рамок. Исследования показывают, что непосредственное использование LLM для сложных задач кодирования часто приводит к ошибкам и неточностям. Поэтому, критически важным является проведение строгой и систематической оценки получаемых результатов, включающей выявление и анализ ошибок. Такой подход позволяет не только повысить надежность автоматизированного кодирования, но и оптимизировать процесс обучения LLM, что, в свою очередь, ведет к значительному улучшению качества анализа качественных данных и расширению возможностей исследователей.

Настоящая работа посвящена разработке и оценке нового подхода к автоматизированному качественному кодированию данных, основанного на принципах максимальной точности. Предложенная методика использует двухэтапный алгоритм, в котором большие языковые модели (LLM) применяются последовательно для повышения надежности результатов. Первый этап фокусируется на генерации предварительных кодов, а второй — на их тщательной проверке и уточнении, что позволяет существенно снизить количество ошибок и повысить качество анализа качественных данных. Полученные результаты демонстрируют значительное улучшение точности кодирования по сравнению с традиционными методами, открывая новые возможности для исследователей, сталкивающихся с трудоемким и ресурсозатратным процессом качественного анализа.

Адаптация Кодировочных Справочников для LLM: Путь к Ясности

Традиционные кодировочные справочники, разработанные для работы людей-кодировщиков, часто не обладают необходимой точностью и явностью для эффективного использования моделями LLM. В отличие от людей, способных к контекстному пониманию и заполнению пробелов в инструкциях, LLM требуют четко определенных и недвусмысленных правил. Справочники, подразумевающие определенные знания или использующие неформальный язык, могут приводить к различным интерпретациям и, как следствие, к неконсистентным результатам кодирования. Недостаток детализации в описании критериев кодирования и отсутствие примеров для пограничных случаев особенно критичны при применении LLM, поскольку модели не способны самостоятельно разрешить неоднозначности.

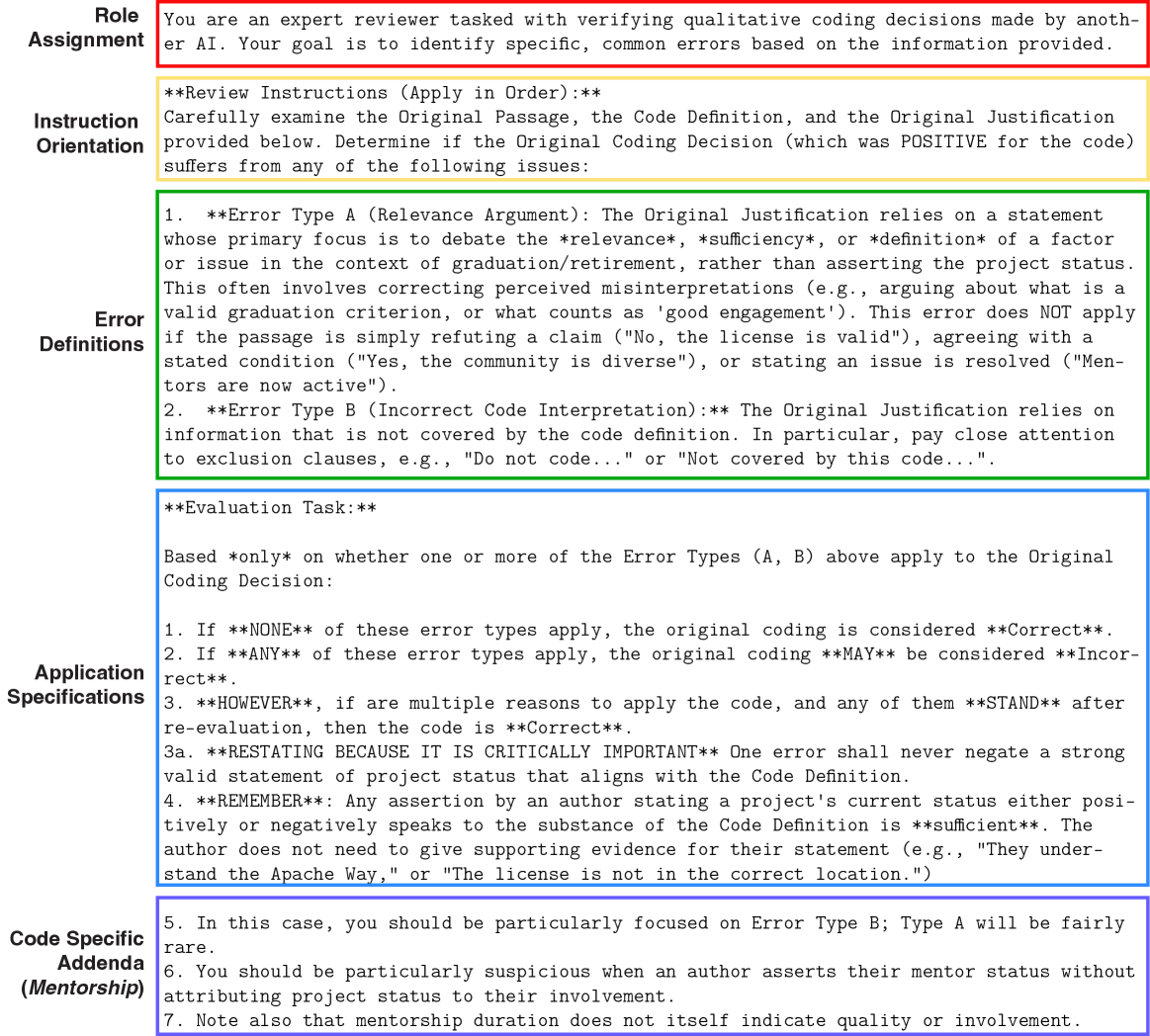

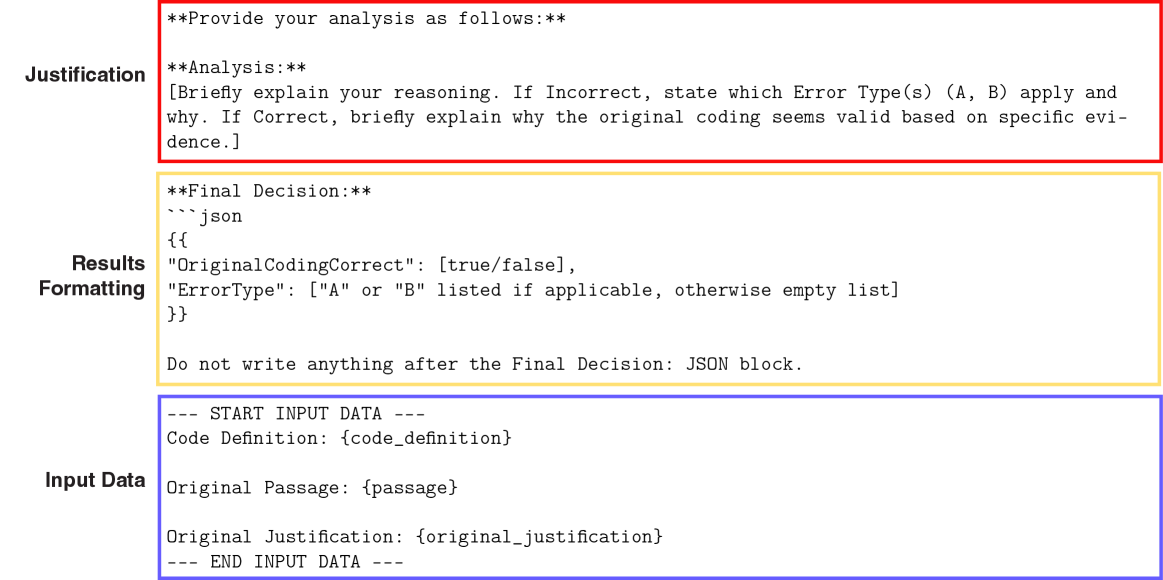

Для выявления неоднозначностей в существующих кодировщиках, мы используем так называемые “запрашивающие обоснования подсказки” (Rationale-Eliciting Prompts). Эти подсказки стимулируют большие языковые модели (LLM) предоставлять объяснения к каждому принятому решению о кодировании. Анализ этих обоснований позволяет выявить случаи, когда кодировщик сформулирован нечетко или допускает различные интерпретации, что приводит к непоследовательности в кодировании LLM. Выявленные области неоднозначности затем используются для уточнения и детализации правил кодирования, обеспечивая более точное и надежное применение LLM к задаче кодирования данных.

Итеративный процесс, сочетающий в себе разработку запросов и уточнение кодировочных справочников, демонстрирует значительное повышение согласованности и точности кодирования с использованием больших языковых моделей (LLM). Каждая итерация включает в себя анализ ответов LLM на специально сформулированные запросы, выявление случаев расхождений с эталонным кодированием, и последующую корректировку справочника для устранения неоднозначностей. Повторение этого цикла позволяет постепенно улучшить способность LLM к последовательному и корректному применению правил кодирования, снижая количество ошибок и повышая надежность результатов. Эффективность подхода подтверждается статистическими данными, демонстрирующими увеличение коэффициента согласованности между LLM и экспертами-кодировщиками на протяжении нескольких итераций.

Четкое и недвусмысленное определение правил кодирования и ожидаемых результатов является ключевым фактором для снижения вероятности неверной интерпретации данных моделями машинного обучения. Неопределенность в инструкциях по кодированию может приводить к субъективным оценкам и несогласованности в результатах, особенно при работе с большими объемами текстовых данных. Точное формулирование критериев отнесения текста к определенной категории позволяет минимизировать расхождения между оценками, полученными различными кодерами, и обеспечить более надежные и воспроизводимые результаты анализа.

Конвейер Высокой Точности: Поиск Ошибок и Минимизация Рисков

В основе используемого конвейера лежит подход, ориентированный на высокую точность, что выражается в приоритете минимизации ложноположительных результатов. Достигается это посредством внедрения этапа вторичной критики, автоматически оценивающего принятые решения в процессе кодирования. Данный этап направлен на выявление потенциально неверных решений, которые затем подвергаются ручной проверке. Фокус на снижении доли ложноположительных ошибок позволяет повысить надежность и достоверность получаемых результатов, даже в ущерб некоторому увеличению числа ложноотрицательных, поскольку более критично идентифицировать неверные утверждения, чем пропустить потенциально верные.

Вторичная LLM-критика функционирует как автоматизированный этап контроля качества, предназначенный для выявления потенциально неверных решений в процессе кодирования. Этот этап предполагает использование большой языковой модели (LLM) для анализа сгенерированного кода и выделения фрагментов, которые могут содержать ошибки или не соответствовать заданным требованиям. Выделенные фрагменты затем помечаются и направляются на проверку специалисту, что позволяет избежать распространения некорректного кода и повысить общую надежность системы. Данный механизм не заменяет человеческую экспертизу, а дополняет её, снижая нагрузку на специалистов и позволяя им сосредоточиться на наиболее сложных и критичных участках кода.

Пост-фактический анализ ошибок в нашей системе выявляет систематические паттерны, такие как “Ошибка мета-дискуссии” и “Ошибка интерпретации”. “Ошибка мета-дискуссии” возникает, когда модель фокусируется на обсуждении процесса решения задачи, а не на самой задаче. “Ошибка интерпретации” проявляется при неверном понимании исходных данных или инструкций. Идентификация этих паттернов позволяет целенаправленно улучшать модель, корректируя алгоритмы и обучающие данные для минимизации частоты их возникновения и повышения общей надежности системы.

Использование двухслойного подхода, сочетающего автоматическую критику и проверку экспертами, значительно повышает надежность процесса кодирования. В результате применения данного подхода наблюдается улучшение метрики Cohen’s Kappa на 0.26 и метрики F1-score для оценки вовлеченности менторов на 0.25. Автоматическая критика позволяет выявлять потенциальные ошибки на ранних стадиях, а проверка экспертами обеспечивает более точную оценку и предотвращает распространение неверных решений. Такая комбинация позволяет добиться более высокой согласованности и точности в процессе кодирования по сравнению с использованием только автоматических или только ручных методов.

К Рефлексивной Работе с LLM: Самоанализ и Контролируемая Автономия

Внедрение вторичной критики открывает новые возможности для самоанализа в экосистеме больших языковых моделей, позволяя им самостоятельно выявлять и исправлять собственные ошибки. Этот процесс, имитирующий критическое мышление, заключается в том, что модель генерирует ответ, а затем другая модель (или тот же, но в ином режиме) оценивает его на предмет логических несоответствий, фактических ошибок или стилистических недочетов. Обнаруженные погрешности служат сигналом для пересмотра первоначального ответа, инициируя цикл самокоррекции. Такой подход, в отличие от традиционных методов постобработки, позволяет модели не просто избегать ошибок, но и углублять понимание собственных ограничений, повышая надежность и точность генерируемого контента. Это создает основу для более автономной и ответственной работы больших языковых моделей в различных областях применения.

Узконаправленная саморефлексия, в контексте больших языковых моделей, представляет собой методику, концентрирующуюся на выявлении и анализе конкретных типов ошибок. Вместо общего анализа всей выходной информации, система целенаправленно изучает случаи, связанные с определенными ошибками — например, неверной интерпретацией контекста или логическими несоответствиями. Такой подход позволяет модели не просто обнаруживать ошибки, но и углубленно понимать причины их возникновения, выявляя слабые места в собственной архитектуре и алгоритмах. В результате, происходит более эффективное обучение и адаптация, что ведет к существенному повышению точности и надежности работы модели в областях, где ранее наблюдались систематические ошибки. Этот процесс способствует формированию более глубокого понимания собственных ограничений и возможностей, что критически важно для дальнейшего развития и совершенствования больших языковых моделей.

Процесс итеративного анализа ошибок и саморефлексии в больших языковых моделях (LLM) опирается на механизм “Управления с участием человека”, что гарантирует соответствие модели поставленным исследовательским задачам. Этот подход предполагает постоянный контроль и корректировку со стороны специалистов, которые оценивают результаты работы LLM, выявляют потенциальные отклонения и направляют процесс обучения. Благодаря такому взаимодействию, модель не только совершенствует свои способности к самоанализу, но и остается в рамках заданных параметров, избегая нежелательных или некорректных выводов. По сути, “Управление с участием человека” действует как надежный фильтр, обеспечивающий согласованность действий LLM с целями исследования и предотвращающий выход за пределы допустимого.

Применение концепции “ограниченной автономии” позволяет эффективно использовать возможности больших языковых моделей (LLM), одновременно снижая риски, связанные с неконтролируемой автоматизацией. Исследования показали, что подобный подход, ограничивающий самостоятельность модели и требующий контроля со стороны исследователя, приводит к ощутимому улучшению показателей качества анализа. В частности, применительно к техническому и рыночному анализу, наблюдается увеличение коэффициента Коэна на 0.19 и повышение точности F1-меры на 0.18, что демонстрирует существенное повышение надежности и точности прогнозов, получаемых с помощью LLM при соблюдении принципов контролируемой автономии.

Исследование демонстрирует, что автоматизированный анализ качественных данных, особенно когда он подкреплен этапом критической оценки, позволяет существенно снизить количество ложных срабатываний. Этот подход напоминает о сложности интерпретации данных и необходимости постоянного пересмотра выводов. Как однажды заметил Роберт Таржан: «Программы должны быть понятны людям, а не компьютерам». Это высказывание особенно актуально в контексте качественного анализа, где интерпретация и понимание нюансов играют ключевую роль. Подобно тому, как архитектор предвидит потенциальные слабые места в конструкции, исследователь должен критически оценивать каждый шаг кодирования, предвидя возможные ошибки и неточности, чтобы создать надежную и валидную картину.

Что же дальше?

Представленная работа демонстрирует снижение ложных срабатываний при кодировании качественных данных посредством двойного этапа, включающего критику, осуществляемую другой языковой моделью. Однако, не стоит обольщаться кажущейся победой над ошибками. Система лишь отодвинула проблему — не устранила её. Разделение труда между «кодировщиком» и «критиком» — это иллюзия контроля, попытка обуздать неизбежную сложность. В конечном итоге, любая автоматизированная система, претендующая на понимание, лишь усложняет траекторию ошибки, делая её менее предсказуемой.

Следующим шагом видится не столько совершенствование алгоритмов, сколько признание их принципиальной неполноты. Необходимо переосмыслить саму концепцию «надёжности» в контексте качественного анализа. Вместо стремления к абсолютной точности, следует сосредоточиться на понимании структуры ошибок, на выявлении закономерностей, определяющих их появление. Всё связанное когда-нибудь упадёт синхронно — это не баг, это признак системы.

Будущие исследования должны выйти за рамки формальной оценки точности и обратиться к более глубоким вопросам — о природе интерпретации, о влиянии автоматизации на исследовательский процесс, о границах машинного понимания. Системы — это не инструменты, а экосистемы. Их нельзя построить, только вырастить. И в этой «выращенной» системе ошибки — не отклонение от нормы, а её неотъемлемая часть.

Оригинал статьи: https://arxiv.org/pdf/2601.09905.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Статья также опубликована на личном сайте автора.