Аналитика и данные

Большие Данные: От Алгоритмов к Масштабируемым Решениям

Автор: Денис Аветисян

- Преодоление Дефицита Данных в Анализе Тональности

- Улучшение Данных с Помощью Продвинутой Предварительной Обработки

- Уточнение Представления Признаков для Повышения Точности

- Масштабирование до Более Крупных Наборов Данных: IMDb и За Его Пределами

- Обработка Данных в Крупном Масштабе с Apache Spark

- Куда же дальше?

В статье рассматривается сравнительный анализ методов машинного и глубокого обучения для обработки многомерных данных в локальных и распределенных вычислительных средах.

Оценка производительности алгоритмов машинного обучения и глубокого обучения при обработке больших данных с использованием Spark и оптимизированных методов предобработки на различных наборах данных (Epsilon, Rest-Mex, IMDb).

Обработка высокоразмерных данных часто сталкивается с ограничениями масштабируемости и вычислительной сложности. В работе, посвященной теме ‘High-Dimensional Data Processing: Benchmarking Machine Learning and Deep Learning Architectures in Local and Distributed Environments’, детально исследуются подходы к преодолению этих трудностей посредством сравнительного анализа архитектур машинного и глубокого обучения. Показано, что оптимизация алгоритмов, применение продвинутых методов предварительной обработки данных и использование масштабируемой инфраструктуры на базе Apache Spark позволяют существенно повысить производительность моделей на разнородных наборах данных, таких как Epsilon, Rest-Mex и IMDb. Какие перспективы открываются для дальнейшего развития распределенных вычислений в контексте анализа больших данных и построения интеллектуальных систем?

Преодоление Дефицита Данных в Анализе Тональности

Анализ тональности, особенно при работе с узкоспециализированными наборами данных, такими как отзывы мексиканских туристов (Rest-Mex Dataset), часто сталкивается с проблемой недостатка информации. Ограниченное количество примеров в таких наборах данных существенно снижает эффективность моделей, препятствуя их способности точно распознавать тонкие нюансы мнений и региональные особенности. Недостаток данных создает серьезные трудности для обучения надежных и точных систем анализа тональности, поскольку модели испытывают дефицит информации, необходимой для обобщения и выявления закономерностей в языке. Это особенно актуально для специфических доменов, где лексика и выражения могут значительно отличаться от общепринятых стандартов, что усугубляет проблему недостатка данных и требует разработки специализированных подходов к обработке и анализу текстовой информации.

Недостаток данных в анализе тональности, особенно при работе с узкоспециализированными наборами, такими как отзывы мексиканских туристов, существенно снижает эффективность моделей. Это проявляется в неспособности уловить тонкие оттенки мнений и региональные различия в языковых выражениях. Модели, обученные на ограниченном объеме информации, зачастую обобщают данные некорректно, игнорируя специфические особенности лексики и грамматики, характерные для отдельных регионов или групп пользователей. В результате, анализ может выдавать неточные или предвзятые результаты, не отражающие реальное восприятие и отношение к объекту оценки. Учет этих нюансов критически важен для получения достоверной и полезной информации из данных.

Традиционные методы анализа тональности часто демонстрируют ограниченную способность к обобщению при работе с небольшими объемами обучающих данных. В частности, при анализе нишевых наборов данных, таких как отзывы мексиканских туристов, это приводит к снижению точности выявления тонких нюансов и региональных особенностей. Для преодоления этой проблемы были разработаны инновационные техники увеличения данных и предварительной обработки, позволившие значительно повысить эффективность моделей. В результате применения этих методов на наборе данных Rest-Mex удалось достичь точности в 86.26%, что свидетельствует о перспективности предложенного подхода к решению проблемы дефицита данных в анализе тональности.

Улучшение Данных с Помощью Продвинутой Предварительной Обработки

Для решения проблемы нехватки данных в наборе Rest-Mex мы применили ряд методов предварительной обработки. В качестве начального этапа представления текстовых данных был использован CountVectorizer, алгоритм, который преобразует текст в численную матрицу, подсчитывая частоту встречаемости каждого слова в каждом документе. Этот подход позволяет представить текстовую информацию в формате, пригодном для использования в алгоритмах машинного обучения, и служит основой для дальнейших этапов обработки и анализа данных. Полученная матрица частот слов является разреженной, что требует использования эффективных методов хранения и вычислений.

Для увеличения объема обучающей выборки применялась техника обратного перевода (Backtranslation). Данный метод предполагает автоматический перевод текста на целевом языке на другой язык, а затем — повторный перевод обратно на целевой язык. В результате генерируются синонимичные, но отличные от исходных, примеры, позволяющие искусственно расширить датасет без сбора новых данных. Этот подход позволяет повысить устойчивость модели к вариациям в формулировках и улучшить обобщающую способность, особенно в условиях ограниченного объема исходных данных.

Для решения проблемы дисбаланса классов, часто встречающейся при анализе тональности, был применен метод Ring Technique — метод понижающей выборки (undersampling). Суть метода заключается в последовательном удалении экземпляров доминирующего класса до тех пор, пока количество экземпляров в каждом классе не станет более сбалансированным. В ходе реализации, для каждого класса определялся минимальный размер, после чего экземпляры наиболее распространенного класса удалялись итеративно, пока не достигалось соответствие этому минимальному значению. Такой подход позволяет снизить смещение модели в сторону доминирующего класса и улучшить её способность к обобщению для менее представленных классов.

Уточнение Представления Признаков для Повышения Точности

Для создания устойчивых векторных представлений признаков в наборах данных Rest-Mex и IMDb был применен метод TF-IDF (Term Frequency-Inverse Document Frequency). TF-IDF позволяет выявить наиболее информативные термины в каждом документе, оценивая их частоту в данном документе и редкость во всей коллекции документов. В результате, признаки, характеризующиеся высокой частотой в конкретном документе и низкой частотой в корпусе в целом, получают больший вес при формировании векторного представления, что способствует повышению точности моделей машинного обучения. Этот подход позволяет эффективно отфильтровать часто встречающиеся, но не несущие существенной смысловой нагрузки слова, такие как предлоги и артикли, и сфокусироваться на терминах, которые наиболее релевантны для конкретного документа.

Для учета контекстуальных нюансов при обработке датасета Rest-Mex была интегрирована предварительно обученная языковая модель BETO. BETO, разработанная специально для испанского языка, позволяет более эффективно извлекать признаки, учитывая семантические связи между словами в предложении. Внедрение BETO позволило получить векторные представления текстов, отражающие не только частоту встречаемости отдельных терминов, но и их значение в конкретном контексте, что повысило точность анализа и классификации текстов на испанском языке в рамках датасета Rest-Mex.

Для дальнейшей оптимизации процесса извлечения признаков использовался метод HashingTF в сочетании с TF-IDF. HashingTF выполняет хеширование терминов, преобразуя их в индексы, что позволяет значительно снизить потребление памяти по сравнению с традиционным представлением в виде разреженной матрицы. Это особенно важно при работе с большими корпусами текстов, такими как Rest-Mex и IMDb Dataset. Комбинирование HashingTF с TF-IDF позволяет сохранить информацию о частоте встречаемости терминов () и их важности в контексте всего корпуса (), при этом минимизируя вычислительные затраты и объем памяти, необходимый для хранения признаков.

Масштабирование до Более Крупных Наборов Данных: IMDb и За Его Пределами

Для повышения качества и полноты обучающего набора данных IMDb применялась методика контекстуальной импутации. Этот подход позволил эффективно обработать пропущенные значения, используя взаимосвязи между различными характеристиками фильмов и актерами. Вместо простого заполнения средними значениями или удаления неполных записей, контекстуальная импутация учитывает окружение каждого пропущенного значения, предсказывая его наиболее вероятное значение на основе сопоставимых данных. В результате, модель получила более надежный и репрезентативный набор данных для обучения, что способствовало повышению точности прогнозирования и общей эффективности анализа.

Исследование продемонстрировало высокую предсказательную способность регрессионной модели XGBoost при работе с набором данных IMDb. Оптимизация параметров модели посредством метода Grid Search позволила достичь показателя среднеквадратичной ошибки (RMSE) в размере 0.6001. Этот результат указывает на высокую точность прогнозов, а коэффициент детерминации , равный 0.79, свидетельствует о том, что 79% дисперсии целевой переменной объясняется моделью. Полученные метрики подтверждают эффективность XGBoost в задачах прогнозирования, основанных на данных о фильмах и рейтингах IMDb.

Разработанные ранее методы, первоначально примененные к набору данных Rest-Mex, продемонстрировали свою адаптивность и высокую эффективность при работе с более крупными и признанными базами данных, такими как IMDb. В результате применения этих техник, включая контекстуальную импутацию и оптимизированный алгоритм XGBoost, удалось достичь показателя AUC-ROC в 95.04% при обработке данных IMDb. Особого внимания заслуживает использование распределенных вычислений, позволивших эффективно масштабировать процесс анализа и обработки больших объемов информации, что подтверждает потенциал данного подхода для работы с еще более масштабными задачами и наборами данных.

Обработка Данных в Крупном Масштабе с Apache Spark

Для обработки чрезвычайно больших наборов данных, таких как набор данных Epsilon, была реализована конвейерная система обработки данных на основе Apache Spark и Scala. Этот подход позволил эффективно распараллеливать вычисления и масштабировать методы анализа до объемов, ранее недоступных. Использование Spark обеспечило распределенную обработку данных, что значительно сократило время выполнения операций и позволило справиться с огромными объемами информации, характерными для современных задач анализа данных. В результате, удалось создать надежную и масштабируемую систему для работы с данными любого размера, что является ключевым фактором в современных исследованиях и приложениях машинного обучения.

Для обработки чрезвычайно больших наборов данных, таких как набор Epsilon, была реализована система параллельной обработки, позволившая значительно расширить возможности анализа. Благодаря использованию Apache Spark и Scala стало возможным масштабирование методов обучения, ранее недоступных для таких объемов информации. В результате, обучение модели Linear SVC на наборе Epsilon заняло всего 136.57 секунд, что демонстрирует эффективность предложенного подхода и открывает новые перспективы для работы с данными, требующими значительных вычислительных ресурсов. Данное решение позволило существенно сократить время обработки и повысить производительность алгоритмов машинного обучения на больших данных.

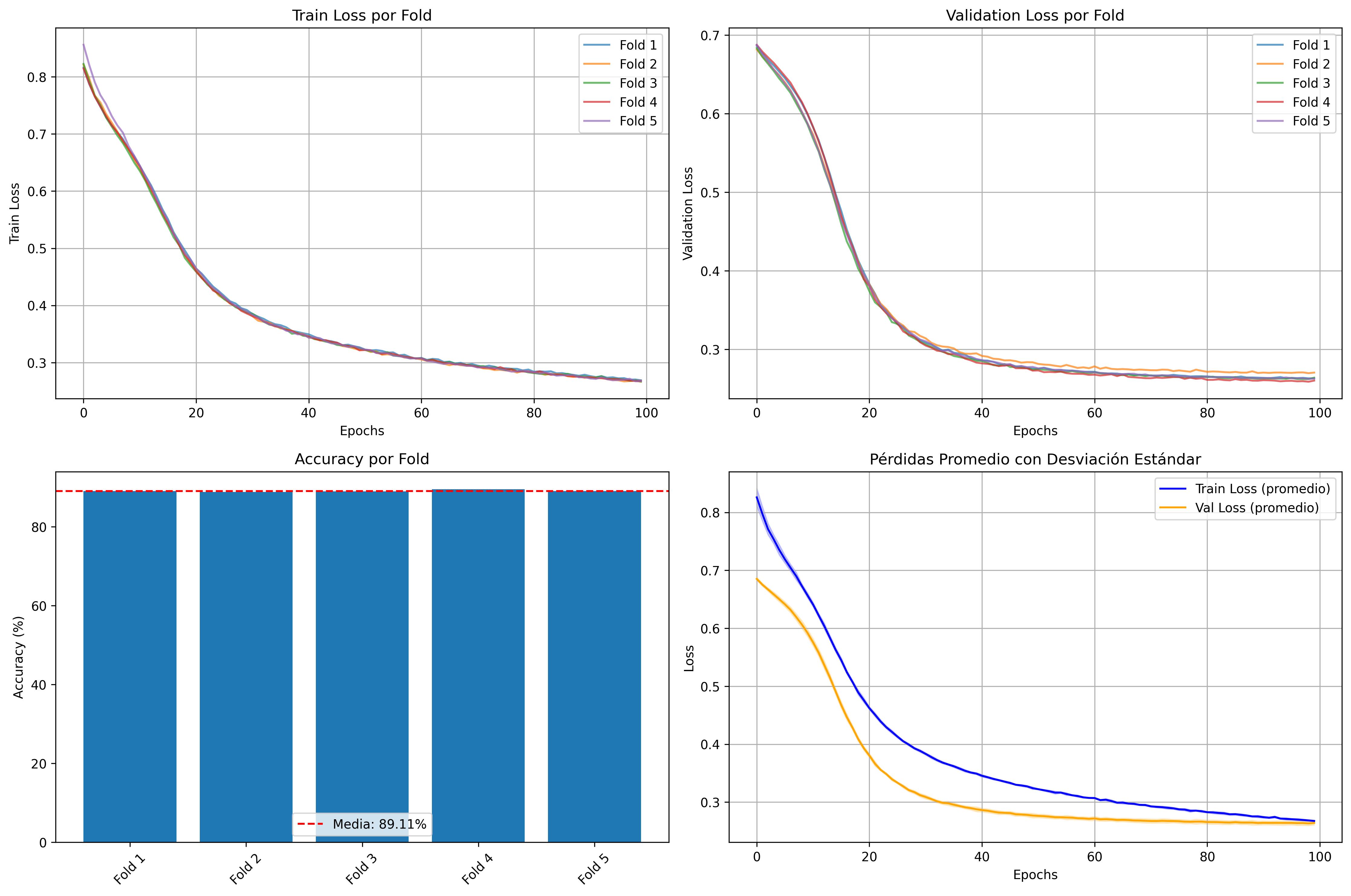

Для обучения на крупномасштабном наборе данных Epsilon был применен алгоритм Pegasos, использующий метод стохастического градиентного спуска. Данный подход позволил достичь точности в 89.18% при обработке Epsilon, демонстрируя масштабируемость разработанного метода. В процессе анализа и прогнозирования рейтингов фильмов, применение Pegasos позволило получить итоговое значение AUC-ROC до 95.04%, что подтверждает эффективность алгоритма при работе с большими объемами данных и сложными задачами машинного обучения. Использование стохастического градиентного спуска позволило значительно ускорить процесс обучения и повысить общую производительность системы.

Исследование, представленное в данной работе, демонстрирует стремление к математической чистоте в обработке больших данных. Авторы последовательно оптимизируют алгоритмы и инфраструктуру, стремясь к доказуемо корректным решениям. Этот подход особенно заметен в применении методов масштабируемого вычисления, таких как Spark, для обработки разнообразных наборов данных, включая IMDb и Rest-Mex. Как говорил Давид Гильберт: «Вся математика должна быть сведена к логике». Эта фраза отражает суть работы, в которой логика и доказуемость алгоритмов являются основой для достижения высокой производительности и надежности в задачах машинного обучения и глубокого обучения. Оптимизация моделей и выбор подходящих методов импутации данных рассматриваются не просто как практические шаги, а как логическое следствие стремления к идеальному решению.

Куда же дальше?

Представленные исследования, безусловно, демонстрируют прогресс в обработке многомерных данных, но не стоит обманываться кажущейся эффективностью. Если модель показывает хорошие результаты на наборе данных Epsilon, Rest-Mex или IMDb — это лишь говорит о том, что инвариант, определяющий её устойчивость, ещё не выявлен. Оптимизация алгоритмов и масштабируемая инфраструктура — необходимые, но недостаточные условия. Главная проблема остаётся прежней: способность обобщать, а не просто запоминать закономерности в конкретных наборах.

Будущие исследования должны быть сосредоточены не столько на увеличении вычислительной мощности, сколько на разработке алгоритмов, способных к формальной верификации. Если решение кажется магией — значит, вы не раскрыли инвариант. Необходимо переходить от эмпирических наблюдений к математически строгим доказательствам корректности. Особенно остро стоит вопрос о применении формальных методов к глубоким нейронным сетям — «черным ящикам», поведение которых зачастую не поддаётся анализу.

В конечном счёте, истинная элегантность не в скорости вычислений, а в математической чистоте алгоритма. Задача состоит не в том, чтобы «настроить» модель, а в том, чтобы построить её на прочном фундаменте логики и доказательств. И только тогда можно будет говорить о настоящем прогрессе в области обработки больших данных.

Оригинал статьи: https://arxiv.org/pdf/2512.10312.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Статья также опубликована на личном сайте автора.